NUS新研究 | 让AI透过我们的眼睛看世界

编者按

第三视角观看世界并与之互动,与从第一视角体验动作之间存在显着差异,这种差异类似于从地面观看其他人乘坐过山车,和自己乘坐过山车——最终形成的过山车体验和理解完全不同。这是目前人工智能 (AI) 及其应用程序所面临的障碍。

新加坡国立大学 (NUS)和世界各地的其他 12 所大学开展合作,以开展一项长期项目——以自我为中心的 4D 实时感知 ( Egocentric 4D Live Perception, Ego4D),利用声音和视觉线索开发具有社交智能的 AI。

![]()

Ego4D的诞生背景

![]()

为了开启下一波人工智能技术浪潮,为增强现实 (AR) 和机器人技术的未来助手和创新提供动力,人工智能需要发展为以自我为中心(即第一人称)感知的全新范式。这意味着在实时运动、交互和多感官观察的背景下,教人工智能通过人眼了解世界。

为此,新加坡国立大学 (NUS)和世界各地的其他 12 所大学开展合作,以开展一项长期项目——以自我为中心的 4D 实时感知 (Ego4D)。

![]()

研究方法

![]()

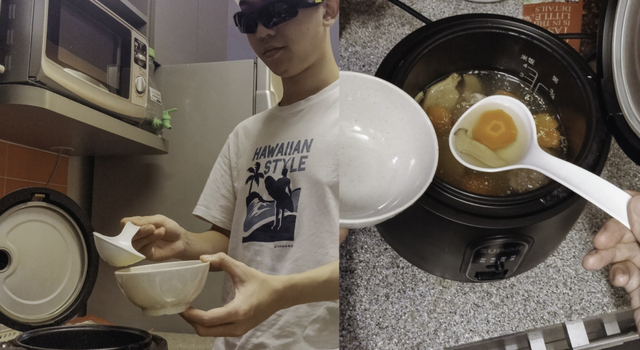

新加坡国立大学电气和计算机工程系的团队一直在积极收集第一视角数据。在 2021 年期间,研究团队将头戴式摄像头和 AR 眼镜总共分发给了当地的 40 名参与者,通过捕捉他们日常场景的平视和第一人称视角的日常活动,例如理发、在小贩中心用餐或去健身房等,来采集数据,并根据收集到的视频数据训练人工智能模型,通过利用音频和视觉线索来理解人与人的互动。

通过在日常场景中收集第一人称视频数据 来源:NUS

NUS 研究团队的助理教授 Mike Shou 说:“在过去的 10 年里,我们见证了人工智能以 ImageNet 等数据为基础在图像理解方面的革命。同样,我相信我们的 Ego4D 数据集将为以自我为中心的视频研究奠定必要的基础,并推动为 AR 和机器人应用构建 AI 模型的显著进展。”

![]()

研究应用

![]()

Ego4D的进步将为人工智能开发更为先进的认知能力提供必要的基本构建模块。事实证明,此类 AI 助手将在我们的日常生活和工作中发挥更大作用。想象一下:在尝试烹饪新食谱时,与其反复参考食谱并尝试,不如戴上一副 AR 智能眼镜,即可指导做菜的每个特定步骤,就好像有一位大厨在旁边指导。

Mike Shou教授解释说:“对于新加坡及其老龄化人口而言,这样的人工智能助手可以为老年人提供特殊的帮助,尤其是那些患有痴呆症或阿尔茨海默氏症等健康问题的人。一副 AR 眼镜可以帮助老年患者记住什么时候发生了什么事,帮助他们记得把钥匙放在哪里,或者是否记得锁门等问题。应用于医疗保健的人工智能助手还可以同时照顾一个病房中的多名患者。”

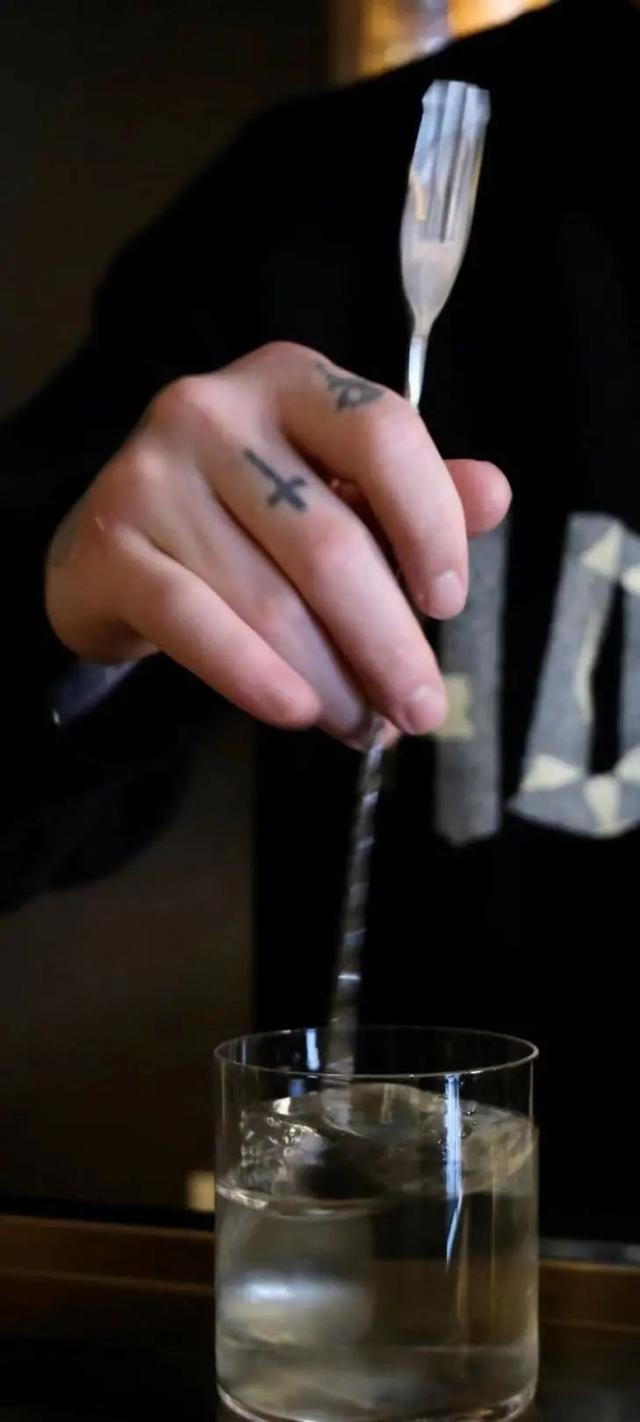

以第一人称和第三人称视角收集的视频数据示例 来源:NUS

![]()

研究进展

![]()

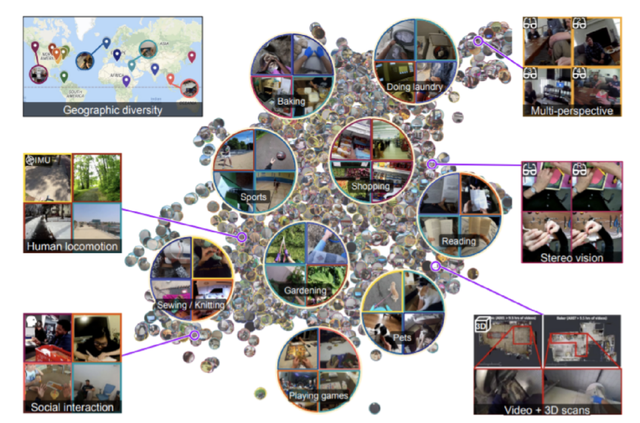

新加坡国立大学团队与其合作伙伴共同收集了来自九个国家的 700 多名研究参与者的超过 3,000 小时的第一人称视频数据,将用于Ego4D的日常训练。Ego4D 是一个大规模的以自我为中心视角的日常生活活动视频数据集,涵盖全球 73 个地点,在场景、人物和活动方面提供了更多的多样性,可以提高针对不同背景、种族、职业和年龄的AI 模型的适用性。

Ego4D 学术联盟数据收集来源图 来源:NUS

这个首创的视频数据集捕捉了相机佩戴者在特定环境中注视的内容,相机佩戴者用手和面前的物体的互动,以及相机佩戴者如何与他人互动。不同文化和地理环境的体验会有很大差异。NUS 团队收集的数据可以代表东南亚人口。

与数据收集同样重要的是,定义正确的任务,进行严格的人工标注,来引导新技术的研发。

为此,Ego4D 学术联盟联合构建了五个全新的、具有挑战性的任务:

(1) 情景记忆:什么时候发生了什么?例如告诉我钱包最近一次出现的位置。

(2) 预测未来:我接下来要做什么?例如下一步要去厨房煮面。

(3) 手与物体交互:我在做什么以及如何做?

(4) 视觉+听觉:多人场景下,谁在什么时候说了什么?例如会议纪要。

(5) 社交交互:人与人如何互动?

“我们NUS研究团队主要为其中两个关键任务开发模型:一是,利用声音和视觉线索帮助AI识别“谁在什么时候说了什么;二是,开发具有社交智能的 AI,检测当下谁在对谁说话,谁在关注谁。”同样来自NUS团队的Co-PI Li Haizhou教授说。

Ego4D数据集只是起点,研发第一视角AI技术将在不远的将来,改变我们的生活、工作、娱乐方式,带给我们前所未有的虚拟与现实交融的体验。

评论