UC伯克利摘最佳论文、Hugging Face获最佳demo

机器之心报道

编辑:魔王、杜伟、小舟

刚刚,正在进行中的 EMNLP 2020 大会公布了一系列奖项,其中最佳论文奖由加州大学伯克利分校的研究者获得,爱丁堡大学华人博士生 Yanpeng Zhao 为一作的论文获得了最佳论文荣誉提名奖(共 4 篇论文获此奖项)。另外,本届大会的最佳 Demo 奖由大家非常熟悉的 Hugging Face 团队摘得。

EMNLP 是国际语言学会(ACL)下属的 SIGDAT 小组主办的自然语言处理领域的顶级国际会议,每年举办一次。受疫情影响,今年的 EMNLP 会议以线上形式举行。

EMNLP 2020 共收到投稿 3677 篇,其中有效投稿为 3359 篇,接收论文数量为 752 篇,包括长论文 602 篇、短论文 150 篇。

从接收率看,EMNLP 2020 的论文接受率创下新低,为 22.4%。其中长论文接收率为 24.6%,短论文接收率为 16.6%。

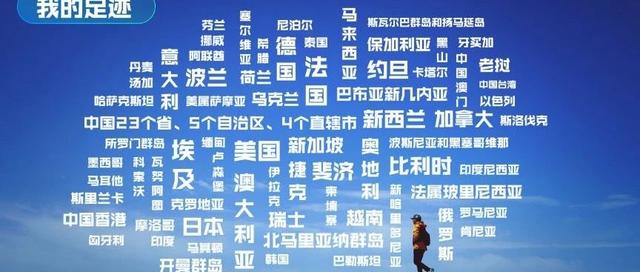

根据大会公布信息,美国、中国、英国、德国、印度、加拿大、日本的论文投稿量最多,中美两国均有 1000 余篇论文投稿。而就各国论文接收率而言,英国、新加坡和丹麦的论文接收率名列前茅,中国的论文接收率仅有 13.2%,低于大会平均接收率。

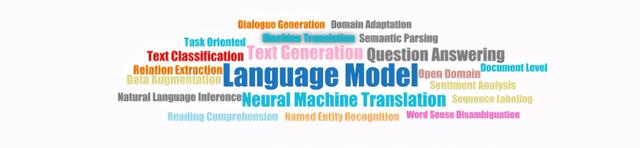

另外,我们参考了 Aminer 平台对于 EMNLP 2020 会议的统计数据。从热门选题来看,EMNLP 2020 会议涉及了语言模型、神经机器翻译、文本生成等主题:

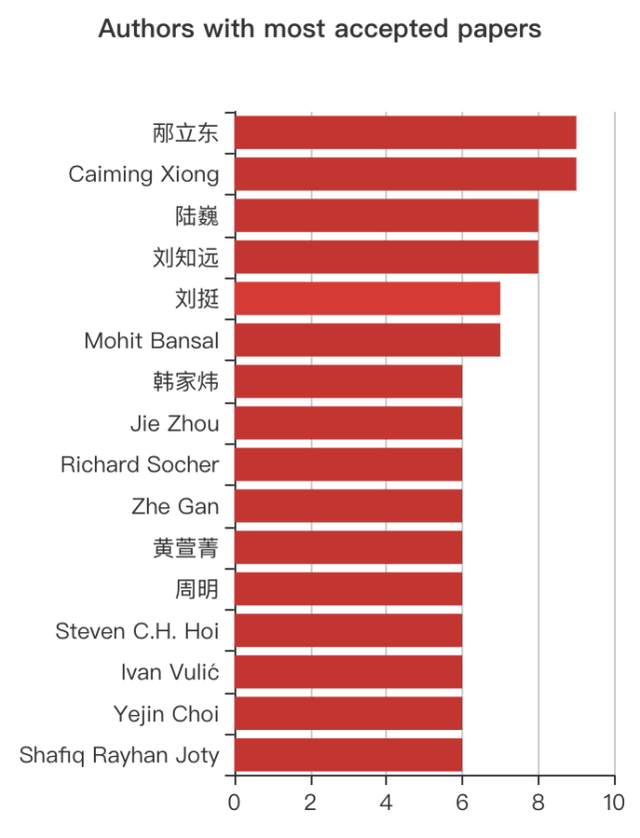

据 Aminer 统计,入选 EMNLP2020 论文最多的学者是来自阿里巴巴达摩院的邴立东和来自 Salesforce AI 研究院的 Caiming Xiong,分别有 9 篇论文入选。此外,新加坡科技设计大学陆巍教授、清华大学刘知远教授、哈尔滨工业大学刘挺教授、伊利诺伊大学韩家炜教授、复旦大学黄萱菁教授、微软亚洲研究院周明博士等人的论文数量位居前列。

图源:https://www.aminer.cn/conf/emnlp2020/papers

目前,EMNLP 2020 会议颁发了最佳论文奖、最佳论文荣誉提名奖、最佳 demo 奖多个奖项。

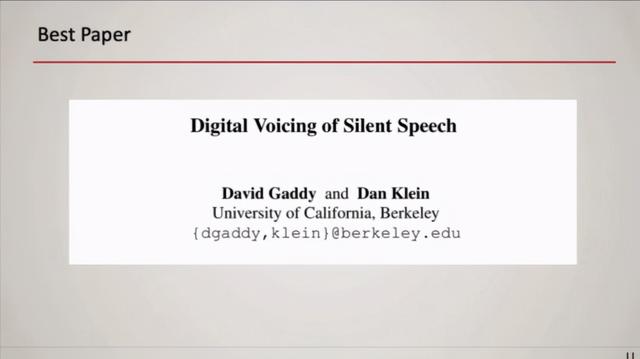

最佳论文

今年的最佳论文奖项颁发给了加州大学伯克利分校的研究《Digital Voicing of Silent Speech》。

论文链接:https://www.aclweb.org/anthology/2020.emnlp-main.445.pdf

作者:David Gaddy、Dan Klein(加州大学伯克利分校)

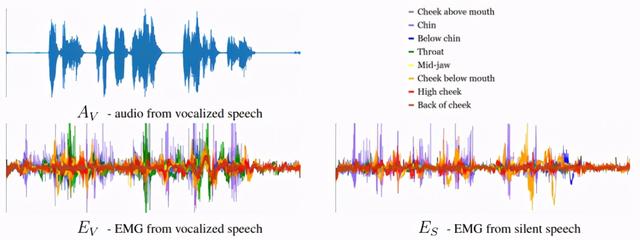

在最佳论文中,来自加州大学伯克利分校的研究者们探究了无声语音的数字化发声任务,其中基于捕获肌肉冲动的肌电图(EMG)传感器度量,将无声口语单词转换为可听语音。尽管此前已经有利用有声语音期间收集的 EMG 训练语音合成模型的研究,但该研究首次利用了在无声发音期间收集的 EMG 进行训练。

模型中所使用数据的三个组成部分。

具体而言,研究者提出了一种通过将音频目标从有声信号转换为无声信号来对无声 EMG 进行训练的方法。与仅使用有声数据进行训练的基线方法相比,该方法显著提升了从无声 EMG 中生成音频的清晰度。在某种数据条件下,该方法将转录词误差率从 64% 降至 4%;另一种数据条件下,转录词误差率从 88% 降至 68%。为了促进这一研究任务的进一步发展,该研究已经共享了无声和有声面部 EMG 度量的新数据集。

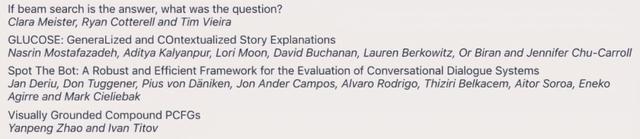

最佳论文荣誉提名奖

这次会议共有四篇论文获得最佳论文荣誉提名奖。其中包括华人作者 Yanpeng Zhao 及其导师 Ivan Titov 的论文《Visually Grounded Compound PCFGs》。据了解,这篇论文获得了 4.5/5, 4.5/5, 4.5/5 的评审分数。

论文:Visually Grounded Compound PCFGs

论文链接:https://arxiv.org/pdf/2009.12404.pdf

项目地址:https://github.com/zhaoyanpeng/vpcfg

作者:Yanpeng Zhao、Ivan Titov(爱丁堡大学)

论文:Spot The Bot: A Robust and Efficient Framework for the Evaluation of Conversational Dialogue Systems

论文链接:https://arxiv.org/pdf/2010.02140v1.pdf

作者:Jan Deriu、Don Tuggener、Pius von Daniken、Mark Cieliebak(苏黎世应用科技大学)、Alvaro Rodrigo(西班牙国立远程教育大学)、Jon Ander Campos、Aitor Soroa、Aitor Soroa(西班牙巴斯克大学)、Thiziri Belkacem(法国 Synapse Développement)

论文:GLUCOSE: GeneraLized and COntextualized Story Explanations

论文链接:https://arxiv.org/pdf/2009.07758.pdf

作者:Nasrin Mostafazadeh、Aditya Kalyanpur、Lori Moon、David Buchanan、Lauren Berkowitz、Or Biran、Jennifer Chu-Carroll(Elemental Cognition 团队)

论文:If beam search is the answer, what was the question?

论文链接:https://arxiv.org/pdf/2010.02650.pdf

作者:Clara Meister(苏黎世联邦理工学院)、Tim Vieira(美国约翰霍普金斯大学)、Tim Vieira(剑桥大学)

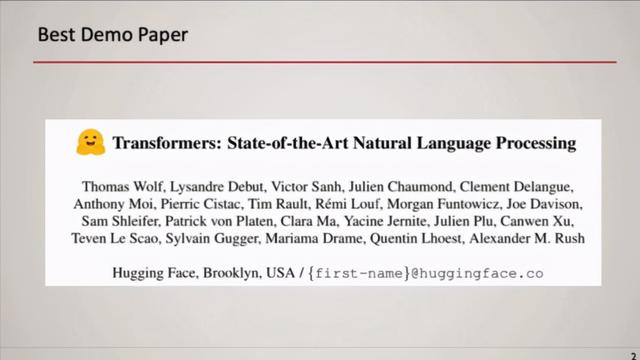

最佳 demo 论文

此外,EMNLP 2020 还颁发了最佳 demo 论文,获奖团队是大家非常熟悉的 Hugging Face。

论文链接:https://arxiv.org/pdf/1910.03771.pdf

transformers 库地址:https://github.com/huggingface/transformers

作者:Thomas Wolf、Lysandre Debut、Victor Sanh、Julien Chaumond、Clement Delangue、Anthony Moi、Pierric Cistac、Tim Rault、Remi Louf、Morgan Funtowicz、Joe Davison、Sam Shleifer、Patrick von Platen、Clara Ma、Yacine Jernite、Julien Plu、Canwen Xu、Teven Le Scao、Sylvain Gugger、Mariama Drame、Quentin Lhoest、Alexander M. Rush(Hugging Face 团队)

模型架构和预训练的发展促进了自然语言处理领域近期的进展:Transformer 架构推动了更高容量模型的构建,预训练使得在大量任务中高效利用模型容量成为可能。Hugging Face 团队创建了 transformers 开源库,旨在将这些 NLP 进展开放给更广泛的机器学习社区。该库包含多个精心设计的 SOTA Transformer 架构,并使用统一的 API。transformers 库汇集了社区构建的多个预训练模型,并向社区开放。目前,该库的 star 量高达 36.9K,包含数千个预训练模型。

参考链接:

https://2020.emnlp.org/blog/2020-11-19-best-papers

https://2020.emnlp.org/blog/2020-09-18-decisions/

https://www.aminer.cn/conf/emnlp2020/homepage

评论