打破常规CMOS,芯仑欲用动态视觉传感器掀起自动驾驶新浪潮

传统摄像头正朝着更高帧率、更大分辨率的方向发展,多传感器融合也被行业定义为自动驾驶实现的必经之路,这带来的是越来越大的数据量。多数软件芯片公司还在寻找如何快速准确处理大量数据的最佳方式,而芯仑科技却将精力放在机器视觉的数据之源——前端摄像头。

11月28日,芯仑科技创始人兼首席科学家陈守顺教授出席合肥高新区举办2018全球物联网创新峰会,进行了关于《颠覆性的物联网感知方案——动态视觉传感器》的主题演讲。

打破常规的 CMOS 图像传感器和图像处理算法,从博士时代开始探究动态视觉传感器的陈守顺,将这项技术应用到自动驾驶创业中。2012年,陈守顺做出第一款动态视觉传感器芯片;2015年,其带领团队在新加坡成立Hillhouse Technology;两年后的夏天,团队回国,公司重新命名为上海芯仑光电科技有限公司。当初的视觉传感器芯片经过多轮产品迭代,目前已经演进至第五代CeleX-V(100万像素,车规级)。

动态视觉传感器路径上的供应商为数不多,芯仑与瑞士的Inilabs、法国的Prophesee、三星(licensed IP)属于同一队列。专注汽车行业的法国咨询公司YOLE曾将动态视觉传感器定义为L4和L5级别的自动驾驶必不可少的传感器之一。

CeleX™动态视觉传感器

传统摄像头提供某一时刻的平面图象,工作方式大致经过重置电荷累计、曝光、输出三个阶段。电荷量根据输入光的强度发生变化,其将捕捉到的光学信息(包括采集点的灰度和颜色)转化成数字信号,实现场景的还原。陈守顺提到传统传感器在数据获取方面依旧存在以下问题:

不连续的数据获取:传统传感器并非连续曝光,采集存在间隔,摄像头仅在曝光阶段观察世界,不曝光时是不看东西的,这造成对物体的追踪存在盲区,丢失了大量物体运动信息,为后端图像处理算法带来问题;

无运动的区域持续输出无效的冗余数据;

快速运动场景下存在图像模糊;

计算资源浪费。

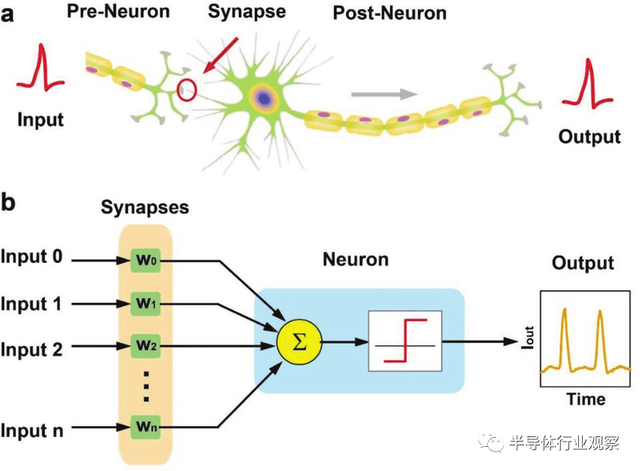

芯仑采用动态视觉传感器(DVS)解决上述问题。基于新型的仿生动态图像传感器芯片技术,芯仑研发出CeleX™动态视觉传感器。陈守顺提到,CeleX传感器的每个像素都能连续的单独监测光强的波动,并在达到阈值时激发事件从而被读出。

雷锋网新智驾了解到,面对快速运动的像素点,常规传感器存在固定帧率、曝光概念,无法准确捕捉完美的运动点。如上图所示,常规传感器拍摄到的多为一段小条,且存在间断。不同于传统CMOS图像传感器,动态视觉传感器没有曝光、帧率概念,没有闲置时间,CeleX动态视觉传感器为连续三维的点云,在X、Y、T空间内对物体运动轨迹进行连续标注,包含像素点运动位置、时间信息,且时间坐标可以精确到纳秒级。

陈守顺将动态视觉传感器喻为“敌不动、我不动”,其每一个像素点可进行独立的运算,在且仅在像素点发生光强变化时进行数据输出,产生较低的数据率。即对于机器视觉而言,物体没有变化时不产生数据流传输,传感器仅对有效的像素点进行记录,从而剔除冗余数据。

由于像素点单独获取数据,并以对数方式进行光电信号的转换,不再受传统的成像参数(曝光时间、白平衡等)影响,CeleX在高动态范围方面表现更好。在特殊场景如隧道出入瞬间,传感器不受光照剧烈变化影响,可以做到场景及运动物体全部清晰,这对自动驾驶的意义很大。

鉴于动态视觉传感器中,芯片的输出数据不受帧率影响,运动频繁的点读出次数会相应增多,因此可以完整记录下打壁球等物体运动的过程。

CeleX传感器对数据进行高速采集,相当于每秒几十万帧,像素点的时间分辨率为5纳秒,动态范围超过120dB。同时具备兼容性,CeleX也能提供传统图像传感器的全副画面,可以兼容使用基于全幅图像的算法,并能在传感器芯片上进行光流运算,提供全分辨率运动矢量信息。

CeleX片上光流模式

陈守顺着重提到一点,CeleX动态视觉传感器输出类似于激光点云,包含三种输出码流方式:

图片模式:和传统图像传感器一致的全幅图像,兼容传统图像处理算法和硬件;

动态模式:通过对自然光强变化的判定输出仿生的动态特征脉冲信号(X、Y、A、T);

光流模式:芯仑独有的密集光流模式,无需降维,从芯片上得到光流向量场信息,直接输出全分辨率运动矢量信息(方向和速度),无需后期算法处理。

这也正是芯仑同其它家动态视觉技术方案解决商的一大不同之处。动态视觉传感路径上共有四家公司:瑞士的Inilabs、法国的Prophesee、三星(licensed IP)及芯仑科技。芯仑最大的优势在于具备三种输出数据格式:动态模式、图像模式及光流模式。Inilabs、Prophesee仅具备前两种输出模式。

雷锋网新智驾了解到,通过传统传感器计算光流非常消耗资源,而CeleX全幅密集光流模式能在芯片采样层级上就能实现。CeleX通过灵活利用三种数据流对算法进行优化,其算法复杂程度在很多场景下能降级上千倍。

车内驾驶员监控和驾驶辅助系统(ADAS)

芯仑将自己定义为机器视觉系统解决方案提供商,CeleX作为一种平台化技术,根据不同的应用场景和市场需求,芯仑提供芯片、技术授权或终端解决方案。面向车载领域,CeleX应用到车内驾驶员监控(DMS)和驾驶辅助系统(ADAS)两大场景。

芯仑选择从后市场切入,基于动态视觉芯片实现驾驶员监控,进行眼睛眨动及面部肌肉的变化情况识别,同样输出三种码流。芯仑目前同物流车队合作进行驾驶员监控产品测试。

芯仑ADAS产品车外ADAS相关,陈守顺提到,跟传统的摄像头技术路径相比,其传感器从感知到芯片组信号处理输出,再到控制指令输出环节速度节省几百毫秒。对于一台时速120公里/小时的行驶车辆而言,CeleX方案将节省5米制动距离。

雷锋网新智驾了解到,专注汽车行业的法国咨询公司YOLE将动态视觉传感器定义为L4和L5级别的自动驾驶必不可少的传感器之一。自动驾驶量产前夜,在ADAS 市场掀起小风浪的动态视觉传感器又能否助力更高级别自动驾驶呢?

评论