UIUC 李博:从技术角度实现 AI 可信,从博弈论、对抗攻击,到逻辑推理

人工智能算法在现实世界中的落地,从来都离不开两个研究范畴:一是模型性能强大可用,二是设计逻辑安全可信。

访谈|李梅、刘冰一

作者|李梅

编辑|陈彩娴

2013 年 4 月 23 日的午后一点,美国各大交易所的平静被骤然打破,办公室里一台台电话响个不停,同时夹杂着工作人员急躁的咆哮声,惊恐与不安的情绪四处窜开。

华尔街的金融精英们正在经历着他们所能想象到的最可怕的危机:

短短 5 秒内,标普市值就被抹去了 1365 亿美元!

股市突然遭遇如此疯狂的大跳水,其直接的导火索是美联社官方推特账户发出的一条仅包含 12 个词的短快讯:

Breaking: Two Explosions in the White House and Barack Obama is injured.(突发:白宫发生两起爆炸,贝拉克·奥巴马受伤。)

这一重磅政治新闻给金融界投放了一颗「信息炸弹」,消息被大量传播后,股票市场顿时陷入一片混乱。

然而,这场风波从开始到结束,只持续了大约 4 分钟。

美联社很快声明白宫遇袭为虚假新闻,白宫发言人也出面表示「总统安然无恙」,各路股票指数旋即回归常规水平,资本市场迅速恢复平静。

数小时后,发布假新闻的幕后黑手也浮出了水面——一个叫做“叙利亚电子军”(Syrian Electronic Army)的、罪行累累的黑客组织黑入了美联社账号。

回看整起事件,引人深思的是:为何社交媒体上的一点风吹草动就能在资本市场引发如此剧烈的反应?

这是因为,在算法赋能金融交易的场景下,股票交易算法在社交网站上抓取到「有价值」的新闻后,会自动执行股票交易行为,从而引发一系列连锁反应。

对人类而言,其实不难识别和求证新闻的真实性,比如当时就有人提醒,美联社一贯的风格是称呼「奥巴马总统」,而不是直呼其名。但对于缺乏常识信息的机器学习模型来说,辨别这一点却很困难,以至于会在真实世界中造成巨大损失。这也是我们以「智能」代替「人工」所可能要承受的代价之一。

在九年后的今天,人工智能和机器学习在现实物理世界中的应用已经变得更加广泛。但 AI 远非万能,机器学习模型在可信任性方面已经暴露出令人忧心的问题。在我们所生活的世界中,不仅有无法识别假新闻的愚蠢的 AI,更存在着危险的 AI。

比如在自动驾驶、智慧医疗等对安全性要求非常高的场景中,模型的「失之毫厘」会带来「差之千里」的危险后果。同时,数据隐私的问题也日益突出。得益于生物信息识别技术的开发,在机场、火车站等场所,人们在机器上刷个脸、摁个指纹,就能方便快捷地完成安检程序。但这些海量的生物信息被采集和存储起来,也为不法分子提供了可乘之机,黑产链买卖盗用人脸信息去实施诈骗的新闻并不罕见。

所以,人类要如何信任 AI ?人类可以放心地把财产管理让渡给算法、把生命健康托付给模型、把隐私信息拱手交给机器吗?

可信 AI ,正是一个致力于让 AI 更安全、让人类对 AI 更放心的一个研究领域,目前也已经有越来越多的研究者意识到可信机器学习的重要性并投入其中,李博便是其中之一,而且是当中的一位佼佼者。

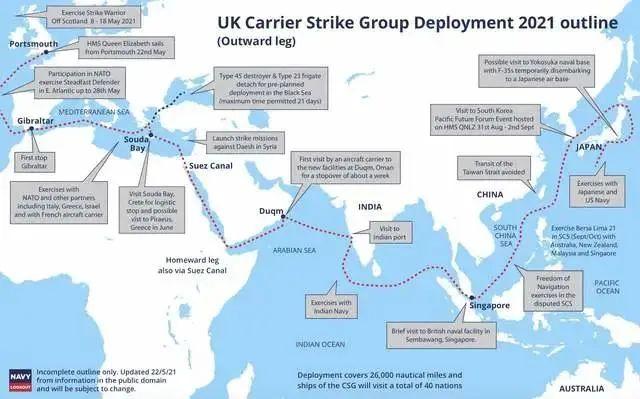

图注:李博在新加坡高校举办的学术论坛上作演讲,以2013年 AI 算法对美国股票的波动影响来诠释可信机器学习研究的重要性

从本科就读同济大学信息安全专业开始,李博就关注到计算机安全问题。之后,她去美国范德堡大学攻读博士,机器学习模型在真实世界中安全性不足的种种现象,让她感到机器学习的安全问题已经非常急迫,便毅然投身于可信 AI 领域的研究。如今,她在伊利诺伊大学香槟分校(UIUC)计算机系领导着安全学习实验室,致力于解决机器学习的可验证鲁棒性、隐私性、泛化性等问题 。

从过去到现在再到未来,李博所要探索的问题始终是:如何让 AI 更安全、更可信?

1 初入「安全」门

李博出生于广东湛江,降生人世还没有多久,就被父母寄予希望,在未来会成为一位博学之才,于是给她取名为「博」。二十七年后,李博果然拿到博士学位,成为人工智能领域一位饶有建树的博士。

上初中后,李博的父母工作繁忙,有时顾不到她的生活与学习,于是决定让李博搬到山西的外婆家。那里的亲戚都是三尺讲台上的老师,这为李博后来的成长创造了优质的环境。在教师家庭耳濡目染的李博,很早就培养了严谨的行为和思考习惯。

李博的家人十分支持她拓展自己的兴趣爱好,比如跳体操、弹钢琴,同时还有意去逐步建立她的科学素养。小时候,李博从《十万个为什么》中获得科学启蒙,再大一些就去读霍金的《时间简史》、《果壳中的宇宙》等等。在好动的年纪,李博却能够沉浸在书本的世界中,去探索世界本质、思考自然原理。从科普读物中,她领略到了自然学科的美妙,尤其是物理和数学。

2007年,李博进入同济大学电子与信息工程学院就读本科,学习信息安全专业。那时,信息安全还算是一个比较新的学科,尽管李博对于这个领域还没有特别深入的认知,但她能强烈地感受到这是一个很重要、很有价值的研究方向。

除了与其他计算机类专业相同的课程外,李博还修读了一些更贴合信息安全的核心课程,包括密码学。作为网络安全的基石,密码学利用算法防范潜在的恶意攻击,以保障信息的安全传输和安全存储,极大地吸引了李博的兴趣。

而大二去台湾交换的一年,更让她在科研实践中真正见识到了关于安全研究的门道。

当时,逢甲大学的张真诚教授到上海访学,就信息安全和计算机密码学领域的发展等话题在高校开展了学术讲座。张真诚主要从事信息安全、密码学和多媒体图像处理三大领域的研究工作,是台湾信息安全界的引领人物、IEEE 和 IET 双料院士,被称为「台湾密码学之父」。十几年过去,虽然李博已经记不清当时讲座的具体内容,但她记得自己在台下听得津津有味、受益匪浅:「当时觉得这些研究非常好玩。」

不久后,李博就看到学校发布了台湾交换生项目的选拔通知,而且还可以申请张真诚教授的交换生名额!于是李博毫不犹豫地填了报名表,最后如愿去了台湾。

在台湾交换期间,李博与张老师实验室里的研究生和博士生们一起做研究、写论文,大部分时间都是非常忙碌且充实的。李博回忆,团队的成员都很努力,经常一起熬夜,通宵赶 deadline,饿了就订一份台湾夜市的海鲜粥来补充能量,然后继续奋战。大家对于科研的热情投入让她深受感动:「感觉那样紧凑的生活非常有意义,觉得就是自己想要的生活。」

在参与科研的过程中,李博对信息安全方向的研究有了更深入的了解,并且还产出了科研成果,发表了一些密码学方向的论文,内容涉及如加解密领域的数字水印研究(Digital water marking)、视觉密码的加解密等。

李博在学术研究上的眼光无疑也是独到且敏锐的。本科四年,李博的科研工作主要侧重于信息安全方向,但她也逐渐开始了对 AI 的接触和学习,并萌生了将 AI 与安全结合起来研究的兴趣和设想。虽然对于未来的研究方向还不甚明确,但她可以确定的是,自己将来想做和计算机安全相关的研究。

彼时,深度学习技术还未崛起,「可信机器学习」这一领域更是尚未诞生,但李博已经颇具前瞻性地预见到它的必将出现:

安全的、可信任的 AI 才是造福人类的 AI。(公众号:雷峰网)

2 AI 模型的「攻防战」

本科毕业后,李博赴美国范德堡大学(Vanderbilt University)攻读博士,师从 Yevgeniy Vorobeychik 教授。

在国内读本科,接着去美国读博,这是李博很早就为自己规划好的道路。申请学校时,李博主要考虑与自己的科研兴趣相匹配的学校。有着「南方哈佛」之称的范德堡大学在安全领域的研究实力很强劲,所以李博没有太多纠结,就选择了这所学校。而且,之前在台湾交换时,她凭借发表的论文,在参加一些会议时与领域内的前辈学者有过不少交流,她的科研成果给他们留下了深刻的印象,这也为她申博成功助推了一把。

李博的导师 Yevgeniy Vorobeychik 教授专注于对抗机器学习领域的研究,尤其是从博弈论的角度去解决机器模型的安全和隐私问题,他主导的研究机构 ISIS (Institute for Software Integrated Systems)在网络物理系统安全领域首屈一指。他与德克萨斯大学达拉斯分校的 Murat Kantarcioglu 教授合著的 Adversarial Machine Learning(《对抗机器学习:机器学习系统中的攻击和防御》)一书,全面论述了机器学习的安全性问题,讨论了各种攻击和防御技术。

图注:李博的博士导师 Yevgeniy Vorobeychik 教授

李博入学后,将机器学习作为自己的科研方向,并思考选择什么样的角度去研究。导师建议她去尝试机器学习安全方向。在当时,这个领域还非常小众,全球从事该领域研究的学者加起来也是屈指可数。导师告诉她,如果她选择这个方向,以她的能力肯定能做出很好的成果,但它在未来的前景如何还不好判断,所以这是一个比较冒险的选择。

听完这番话,李博并没有产生类似的忧虑,相反,这正是她所感兴趣的研究。而且,经过本科在信息安全方面的学习和研究,她相信自己能将安全和机器学习很好地结合起来,能更准确地找到机器学习的安全痛点在哪里。她的选择很有前瞻性,后来深度学习的大火推动了很多技术在真实世界中的落地,安全问题变得更加突出。

Vorobeychik 对于李博在科研上的进展并不急于求成,宽慰她说「第一、第二年只管好好上课,不用太着急」,但他没想到这位中国学生并不想过得太「轻松」,反而 push 起导师来。

「我当时自己其实比较着急,想要赶快写论文、发论文。」李博没有藏着掖着,直接跟 Vorobeychik 表明自己在课程学习方面没什么问题,想要尽快投入科研。经过交谈,导师了解了她的诉求,开始让她参与到科研项目中,而且是做比较难的项目。

李博最初跟着导师做了许多从博弈论角度研究安全问题的项目。博弈论是当时机器学习安全研究所采用的一个主流方法论。机器学习模型的交互过程可以建立为一个博弈模型,在一个博弈(Game)中,有两个参与者,分别是攻击者(Attacker)和防御者(Defender)。研究人员的目标是找出一个均衡博弈状态,即最优解,让防御者赢得博弈,从而提高机器学习模型的鲁棒性。

沿着这个方向,李博做了一系列的研究。比如,在对垃圾邮件和恶意软件进行检测的研究上,对抗性环境中的攻击者通常会故意避开用于检测它们的分类器。为了解决这个问题,李博与导师研究了攻击的目标建模算法,发现常用的「特征筛选」会导致模型更加容易被攻击。为此,他们提出一个基于「Stackelberg Game」的优化学习模型,在特征筛选和对抗规避之间进行权衡,寻求最优解,从而获得鲁棒性算法。这篇论文被 NeurIPS 2014 接收,成为后来很多机器学习安全研究的主要参考工作之一,至今已被引用上百次。

论文地址:https://papers.nips.cc/paper/2014/file/8597a6cfa74defcbde3047c891d78f90-Paper.pdf

随着研究的深入,李博在机器学习模型的安全性方面做出了许多开创性的重要成果。比方说,在被NeurIPS 2016 接收的一项工作中,李博首次提出了针对推荐系统的投毒攻击。投毒攻击(Poisoning Attack),是指在机器学习模型的训练阶段,恶意攻击者可以修改一小部分训练数据,从而使得模型在测试阶段做出符合攻击者预期的错误判断。李博与导师以及 CMU 的学者合作,展示了对协同过滤(Collaborative Filtering)这种系统推荐技术的数据投毒攻击,并提出了相应的防御算法,在真实世界中得到了有效性验证。

论文地址:https://arxiv.org/pdf/1608.08182.pdf

目前,投毒攻击(包括后门攻击)已经在不同的深度学习模型中被广泛研究,而李博的这项早期研究事实上为学界后续的一系列工作奠定了深厚的理论基础。比如最近她和团队提出的针对后门攻击的、可验证的深度学习模型鲁棒性同样是「史上首次」,为防御后门攻击的模型的鲁棒性提供了理论保证。

另外,在隐私数据保护方面,李博开发了可扩展的隐私保护数据生成模型,并用来生成具有隐私保护的医疗病例数据。这项工作还被集成在开源工具 MITRE Identification Scrubber Toolkit (MIST)中。

博士期间的李博一直保持着非常高产出的状态:25篇会议论文,11篇期刊论文,还有各种荣誉奖项。2015年,李博还获得了赛门铁克研究实验室奖学金,该奖项全球仅有 3 人入选,用于奖励在计算机安全领域做出创新性工作的学者。这些成绩都是李博在这五年抓紧每分每秒努力做科研的结果,相信「天才在于勤奋」的她,直到现在也是保持着每天从早上九点工作到凌晨的日常。

2016年,名字带「博」的李博,终于正式成为了一名博士。

李博打算继续留在学术界,这也是她一直以来的规划。她认为,在学术界的好处是可以更自由地去探索一些自己特别感兴趣的问题,即使这些探索可能没法很快「变现」,但从长远来看,它们可能具有很重要的价值。不过,李博也谈到在工业界做研究亦有其不同的优势,比如工业界可以提供更丰富的数据资源,也会提出更多具有实际应用价值的问题。所以,李博后来也去积极地尝试与工业界展开一些合作。

申请教职时,李博在一个月里辗转飞到美国各个城市去面试,最终获得了包括伊利诺伊大学香槟分校(UIUC)在内的多个大学的录取。

在 CS Ranking 上,UIUC 在 AI 领域排名全球第三,那里做机器学习和计算机安全方向的大牛非常多,但当时做「机器学习安全」的学者却没有多少。李博认为这其实是一个很好的机会,未来她的合作者都将是一群非常优秀的科学家,肯定能在科研上获得高质量产出。就这样,李博最终选择了 UIUC。

拿到教职 offer 后,李博选择花一年时间去加州大学伯克利分校做博士后研究,博士后的导师就是全球知名的「计算机安全教母」宋晓冬教授(Dawn Song)。这一年,李博接触和认识了更多可信机器学习的研究者,还拓展了跟工业界的联系,从而注意到更多真实世界中的问题。

李博与宋晓冬在对抗机器学习方面合作了许多重要研究,涉及视觉分类的物理攻击、后门投毒攻击、GAN 生成对抗样本、对抗性子空间的局部内在维度表征、空间转换的对抗样本、物体检测器的物理对抗、深度神经网络的黑盒攻击等等。

其中一项在鲁棒机器学习领域堪称为里程碑式的研究,这便是李博与宋晓冬等人合作的“Robust physical-world attacks on deep learning visual classification”。在这项工作中,他们以自动驾驶中的安全问题为切入点,最早证明了对抗样本对深度神经网络的攻击可以存在于物理世界中。这项工作被 CVPR 2018 接收,在当时产生了极大的领域影响力,多次被《连线》、《纽约时报》、《财富》、IEEE Spectrum 等媒体报道,论文目前已经被引用1800余次,是李博所有论文中被引用次数最多的一篇。

论文地址:https://openaccess.thecvf.com/content_cvpr_2018/papers/Eykholt_Robust_Physical-World_Attacks_CVPR_2018_paper.pdf

以往的对抗机器学习研究主要囿于对数字世界里模型的观察,比如研究者可以对图像的像素加以肉眼无法识别的微小改动,模型就会因此被愚弄和攻击。

而李博想要知道的是,模型的对抗攻击在现实物理世界中是否也会发生?

当时已经有不少研究者都提出了这个重要疑问,但还没有人真的去做验证。李博对这个有趣又有挑战性的问题跃跃欲试,决定选取自动驾驶的 AI 系统对路标的视觉识别作为证明角度。

一般情况下,如果一个 AI 模型在大多数条件下都管用,比方说 90%,那这个模型就已经足够好了;但在性命攸关的自动驾驶场景中,90% 是远远不够的。自动驾驶系统的安全性不足一直是这个行业的痛点,即使攻击者无法攻破系统的「围墙」,但仍可能通过对物理对象进行物理性改动来干扰系统,比如停车标志牌上的图案被人为地涂抹、破坏后,可能会被系统错误地识别成限速标志牌,而车辆的每一次刹车或加减速的决策都需要绝对的安全,否则就有可能酿成惨剧。

因此,弄清楚 AI 系统的易受攻击之处,并了解它为何会被攻击、如何被攻击,进而提高模型的鲁棒性、最终提升自动驾驶系统的安全度,这些都是亟待解决的难题。

然而,要想证明物理世界中的模型同样会有被攻击的潜在危险,并不像在数字世界中那样容易。路标这样的物理对象使对抗性攻击变得更加复杂,路标所处环境的多变性,光照、天气、地面清洁度、距离等因素都会影响生成物理对抗样本的鲁棒性。因此,李博和她的团队设计了新的优化方法来完成对黑盒 AI 系统的物理攻击。

李博带上团队里的几个博士生,去各种场地拍摄了大量的路牌照片来训练模型。他们在停车牌上模拟人的随手涂鸦,贴上黑色或白色的小块贴纸,并且不遮挡路牌上 “STOP” 或右转向箭头的整体样式。

这些贴纸看似随意,但却是经过精心设计的物理干扰,当人类司机看到这样的路牌时,基本上不会认错,但若是一辆自动驾驶汽车向一个写着“STOP SIGN”的路牌驶近,摄像头的感知系统就会将它们误认为是 45 英里/小时的限速标志牌,而不会立即停车。另外,右转向路牌也会被错误识别为停车路牌。

实验显示,无论拍摄标志牌的距离和角度如何,在所有场景下,对自动驾驶车辆系统的物理攻击都是成功的!

掌握了关于这些可能存在的攻击信息后,研究者就可以制定策略来训练出更强大的模型。李博在攻击者和防御者之间建立博弈模型,让 AI 系统相互对抗,使用一个神经网络来识别和利用另一个系统的漏洞。这样一个过程可以让目标网络的训练所具有的缺陷都显露出来,然后就能有效地去修补这些缺陷、防御潜在的攻击。

李博和她的合作者成功地向人们表明,图像分类系统对物理对象的对抗性扰动具有很强的敏感性,这种敏感性在真实世界中的潜在后果是不堪设想的。

如李博所期望的那样,这项研究唤起了人们对物理学习系统可能面临攻击这个事实的重视。不仅在学术界引起热议,而且带来了一波工业界的研究热情。IBM 受到该研究启发,开发了类似的技术为其「初代 AI 界老大哥」 Watson AI 系统提供安全保障。亚马逊将该研究成果运用到智能音箱 Alexa 中。还有一些自动驾驶汽车公司,也在使用该研究来提高机器学习模型的鲁棒性。

这项工作的影响力之大,还吸引了英国伦敦科技博物馆的目光。2019年6月,博物馆正在策划一次藏品展出,鉴于该研究所具有的时代意义,他们联系到李博的团队,买下了对抗路标实物,将其存放在永久收藏柜里。

图注:英国科技博物馆展出李博团队生成的对抗性路标

今天,这块路牌仍然被陈列在这座有着一百五十多年历史的老博物馆里。在可信机器学习的新浪潮下,它仿佛一朵激扬的大浪花,向世人警醒着:AI 技术一次次地经历着令人惊叹的更新换代,但「水满则溢」,技术背后的安全隐患也已经到了不能再假装其不存在的地步。

「通过设计新方法来『愚弄』 AI ,从而使 AI 变得更安全」,这是李博在 2020 年凭借这项成果入选 MIT 科技评论「 35 岁以下的 35 位技术创新者」全球榜单的理由。31岁的她,在对抗机器学习领域已经做出了引领性的出色研究。

结束了一年的博士后研究,李博回到 UIUC 正式开始执教生涯、继续创造新的科研突破。

在先前关于对抗攻击策略的研究的基础上,她提出了一系列新方法来提高 AI 系统的鲁棒性。比如利用数据的时域相关性和空间相关性来检测恶意样本。她利用时域相关性去检测恶意音频样本的工作被收录在 ICLR 2019,后来还被 IBM 应用在 Watson 语音识别系统中。在利用空间相关性来检测恶意对抗图像样本方面,李博也提出了第一个可以有效抵抗自适性攻击的恶意样本识别算法。

图注:利用时域连续性检测恶意语音样本

图注:利用空间连续性检测恶意图像

为了生成更加有效的对抗样本,李博进一步提出了「对抗神经网络」,在 MNIST 对抗攻击挑战赛(Adversarial Attack Challenge) 的排行榜上获得了 Top 1 的成绩,这再次证明了她提出的「对抗样本建模」原则的价值与可行性。同时,在视觉任务上,李博引入一种「无限制对抗性攻击」的方法,通过修改图像的颜色、纹理等细节来对 AI 系统成功实现了攻击,并设立了评估机器学习系统对抗各种攻击的鲁棒性的基准。

在机器学习模型的隐私保护上,李博也再次交出了「第一」的答卷。她和团队提出的 DataLens 模型第一次实现了高维连续数据的具有隐私保证的数据生成。这项工作不仅证明了生成数据满足差分隐私的要求,还首次在理论上证明了这类生成模型的收敛性,系统地分析了系统效率和生成数据质量之间的权衡问题。

图注:具有差分隐私保证的高维数据生成模型

相关论文地址:

https://arxiv.org/pdf/1810.05162.pdf

https://arxiv.org/pdf/1904.06347.pdf

https://arxiv.org/pdf/2103.11109.pdf

3 可信 AI的未来:引入逻辑推理

如今,“可信机器学习/可信人工智能”成为一个热门的研究领域,鲁棒性、隐私性、公平性、可解释性是可信机器学习的四个核心构成,每个方面都有许多学者在探索钻研。李博在 UIUC 领导的「安全学习实验室」小组也正在致力于解决这些子问题。

图注:李博与实验室的学生合影

李博的课题组目前主要开展的工作包括:

可验证的鲁棒性机器学习:优化机器学习模型以对抗恶意攻击,并提供可验证的鲁棒性。

具有隐私保护的机器学习和数据分析:探索差分隐私、同态加密和信息理论分析等技术,在实践中实现隐私保护。

机器学习的泛化性:基于泛化性与鲁棒性、隐私性之间的联系,通过优化其他属性来改进机器学习的泛化性能。

在李博看来,这些问题之间紧密相关:「经过几年研究,我深深地体会到这些子问题之间其实不是相互独立的,它们之间有很本质的内在联系。」

例如,他们证明了在联邦学习中,如果模型满足差分隐私,那么它的鲁棒性也可以被表示为隐私对应的参数;此外,机器学习模型的鲁棒性和模型泛化性在满足某些条件下是可以互为充分条件的。

图注:鲁棒性、隐私性、泛化性之间的关系

目前的可信机器学习还未对这些子问题之间的互相关联予以太多关注,但李博相信,如果可以更多地发掘这些子问题之间本质性的关联,我们就不必重造车轮,而是可以利用一些子问题的研究成果来提供更多原则和理论基础,给其他可信机器学习的子问题带来解决方案。若只单独研究其中的每一个,就会产生重复性劳动,也很难发现最基础、最本质的问题。

秉持着这种研究思路,李博对于课题组内博士生科研方向的「排兵布阵」也是考虑良多。兴趣优先,因材施教,组里11个博士生在可信机器学习的大框架下做着不同方向的研究,有的专攻可验证鲁棒性,有的研究自然语言处理方向的鲁棒性和隐私性问题,还有的学生是从联邦学习的角度来做鲁棒性和隐私性研究,这样大家就可以展开很多有效的合作。

图注:在李博教授的Trustworthy Machine Learning课程期末,博士生展示项目海报

最近,在可信机器学习的研究上,李博又迈出了关键的一步。基于这几年对相关问题的深入思考,她正在探索一种新的方法论——基于逻辑推理的可信机器学习。在李博看来,这就是可信机器学习的未来。

几乎没有模型不会被攻击,问题是,如何防御攻击?近年来,防御攻击的工作正在面临一个难题:当我们检测到攻击时,会研究相应的防御攻击的手段;然而,新的攻击形式很快又会出现,这就需要我们再去找出新的防御方法......所谓「道高一尺,魔高一丈」,攻击防不胜防。这样的循环什么时候才是尽头?

李博认为,可验证的鲁棒性能够终止这种「攻防循环」。

那么,机器学习鲁棒性的可验证性有什么用?

李博介绍,在某些攻击条件下,可验证性本质上可以为模型的精度设置一个下限。比如针对某种攻击的防御手段,其下限为90%,那么就能保证模型的精度不会下降到这个数字以下。也就是说,无论攻击者使出什么招数,只要攻击防御不超过这个界限,就能保证模型的性能。

总体上,可验证鲁棒性有两种研究范式,一种是决定论的,另一种是概率论的,两种角度下各有许多不同的细分路径。但整体来说,它们仍存在一个缺点,即攻击的条件非常有限,目前只能去验证很小一部分的防御方法。

图注:可验证鲁棒性的研究路径

推理,是李博提供给这个问题的解决思路。

目前,几乎所有的机器学习模型都是纯数据驱动的,人类的先验知识、经验、推理等信息都没有被建立模型。这种现状可以说是深度学习革命的大获成功所带来的。在2019年的图灵奖演讲中,Geoffrey Hinton 曾谈到了两种使计算机智能化的方法。其一,他称之为「智能设计」,即将特定任务的知识传授给计算机;其二,便是「学习」,即人类只向计算机提供示例。话里话外,Hinton 都表达了他对第一种方法的否定。

但不得不承认,已有的提高模型鲁棒性所使用的统计方法已经遇到了一个瓶颈,有必要引入一些显性信息,如域知识、逻辑推理等。比如在“Stop Sign”这项研究中,人类基于生活经验,很容易就能从路牌图案的整体轮廓中判断出它是不是一个停车标志,但模型却并不具备这种能力。

因此,李博想到,若能使用逻辑推理来帮助模型,就能获得更好的鲁棒性。我们可以用知识限定攻击条件和场景,比如「在中国车辆靠右行驶」这样的生活常识,以及「如果一个人在横穿马路,车辆行到跟前不停下的话,会发生什么?」这样的因果推理知识。

李博告诉 AI 科技评论,目前,她的团队已经有一些正在进行的项目在实践这种方案,比如用马尔科夫逻辑网络(Markov Logic Networks)来将一阶逻辑表达出来,然后利用概率图模型(Probabilistic Graphical Models )做推理,从而发现并自动纠正纯统计型模型(Statistical Model )被攻击的预测。

他们的研究表明,将人的知识、推理逻辑与纯数据驱动的模型结合起来,确实可以大幅度提高图像和NLP模型的可验证鲁棒性,即使是在大规模数据集上效果也非常好。

图注:感知-推理示例,感知组件由用于其子任务的不同神经网络组成,推理组件是一个因子图。

可信机器学习涵盖机器学习的方方面面。在 NLP 任务中,可信机器学习可以解决错误分词、错误翻译等问题;在视觉方面,可信机器学习则旨在确保模型具有准确的预测能力,且不会被微小的恶意扰动所攻击;在联邦学习中,可信机器学习则更关注如何解决中心模型被恶意用户破坏的问题。这些不同任务有着共同的底层逻辑,那便是预防在训练或者判断阶段中的恶意攻击,保障模型的鲁棒性和数据的隐私性。

所以,李博对可验证鲁棒性的关注也自然地延伸到这些不同的机器学习任务当中,做了一些有益的探索。比如她的团队提出了针对联邦学习和自动驾驶中激光雷达点云识别的可验证鲁棒性,为可验证AI提供了在真实世界场景中的可行性。

图注:联邦学习的可验证鲁棒性

图注:激光雷达点云识别的可验证鲁棒性

在开发算法和可验证方法论的同时,李博和她的团队也为社区贡献了各种基准来帮助训练和评估针对不同任务的算法。例如,他们提出了针对自然语言的大型可信基准 AdvGlue、针对强化学习算法的可验证鲁棒性基准 CROP、 COPA ,以及针对自动驾驶真实场景的安全测试场景基准 SafeBench 等等。「currently data is the oil in the modern world,所以不同的benchmark也会更有效的提高可信AI的生产力」,李博这样解释这些工作的动机。

图注:对抗自然语言基准(地址:https://adversarialglue.github.io)

图注:自动驾驶恶意场景基准(地址:https://safebench.github.io/leaderboard/index.html)

4 人工智能,福兮

AI 的终极归宿是应用在真实世界,造福人类,李博的研究都来源于、扎根在且落回到真实世界中。

在工业界,有许多机器学习模型应用于真实世界,所以安全性是工业界也同样非常重视的问题。李博在这方面与工业界保持着积极合作,比如亚马逊的欺诈检测模型、Facebook广告推荐系统的隐私保护、eBay的交易图等等。

另外,她也与国内的互联网公司如百度、腾讯、蚂蚁等有过鲁棒性和隐私性方面的合作。比如,在与蚂蚁的可信 AI 研究团队的合作中,为了测试他们的人脸识别系统的易受攻击性,李博团队设计算法,在蚂蚁提供的API上进行评估,发现系统果然可以被攻击。她进而提出一些防御攻击的方案,在蚂蚁的平台上实现相应的算法,以防止人脸识别系统遭受恶意攻击,最终收获了不错的效果。

在可信机器学习领域深耕数年,李博的卓越成就已经为她赢得了许多荣誉奖项,比如亚马逊网络服务机器学习研究奖、 Facebook 研究奖、NSF CAREER 奖、英特尔新星奖等等。

今年 2 月,因为在可信机器学习领域的杰出工作,李博获得了具有「诺贝尔奖风向标」之称的斯隆研究奖。值得注意的是,与她一同获奖的还有另外三位人工智能领域的华人女性科学家,她们分别是陈丹琦、方飞和宋舒然。

李博对女性科研工作者的影响力不断扩大感到欣慰:「其实我的组里就有蛮多女生的,我一直觉得女生很能够focus,如果认真做(科研)的话,我觉得可以做得很好,所以我蛮鼓励女性学者能够不要在意周围的眼光,如岁数大之类的评价,就去做自己喜欢做的事情,不要太在意别人,我觉得你就可以做得很好。我觉得女生和男生在科研能力上没有什么差别。」

就在上个月,身为 AI 领域杰出青年科学家的李博,还被授予 IJCAI 2022 年计算机与思想奖,以表彰她在机器学习鲁棒性方面的贡献,包括发现 AI 鲁棒性、隐私性和泛化性之间的内在联系,揭示各种模型的易受攻击性,以及提出数学方法来弥补模型的漏洞,为机器学习模型和隐私保护提供鲁棒性保障。

未来,李博将继续她在可信机器学习领域的探索,为 AI 在真实世界中的应用保驾护航。(公众号:雷峰网)

评论